正规配资公司官网这些大模子的试验情况就是:有几许内存

一周前,苹果低调发布了最新款 Mac Studio,提供 M3 Ultra 和 M4 Max 两种芯片选项。其中,M3 Ultra 版块搭载 32 核 CPU 和 80 核 GPU,最高支握 512GB 斡旋内存。官方声称此版块可运行开头 6000 亿参数的 LLM,也就是在家就能跑满血版的 DeepSeek R1。

这引得不少东谈主安身围不雅,并产生了一些疑问:在 AI 大模子期间,买 Mac Studio 会比买单买 GPU 更合算吗?在 AI 任务中的本色进展,它会比其他高端 PC 进展更强吗?

最近,不少外洋网友在收到新建设后,纷纷入手测试模式。其中,硅谷盘问公司 Creative Strategies 的时刻分析师 Max Weinbach 率先上手 256GB 版 Mac Studio,测试了 QwQ 32B、Llama 8B、Gemma2 9B 等模子,并分享了在不同建设上的评测对比数据。另外还有 YouTube 博主 Dave Lee 顺利把成立拉满,在 512 GB 的 Mac Studio 上跑了满血 DeepSeek R1,那么,Mac Studio 在 AI 范围的进展到底若何?一谈来望望!

话未几说,可以先看论断:

Max Weinba 暗示,Nvidia RTX 5090 在 GPU 基准测试和部分 AI 任务上进展出色,但苹果芯片在使用体验和牢固性上更胜一筹。合适征战者的最好组合是:Mac Studio(M3 Ultra)用于桌面 AI 征战 + 租用 Nvidia H100 处事器作念高强度规划任务。

Dave Lee 暗示正规配资公司官网:macOS 默许对 VRAM 分派有扫尾,需要手动调高了上限,把可用 VRAM 擢升到了 448GB,才让 DeepSeek R1 模子顺利运行。运行弘远的 DeepSeek R1 模子时,扫数这个词系统的功耗不到 200W。如果用传统多 GPU 成立来跑这个模子,功耗起码是 M3 Ultra 的 10 倍。

01 购入 32 核 GPU、搭载 M3 Ultra 的新版 Mac Studio

开头,咱们先看 Max Weinba 的测试历程与经验。自 2020 年购入第一台 M1 MacBook Pro 以来,Max Weinbach 便成为 Apple Silicon 的古道用户。从 M1 MacBook Pro 升级到 M1 Max,再到 M3 Max,他最垂青的永久是内存性能。这不仅是因为 Chrome 浏览器对内存的高需求,更在于他合计,内存永久是影响电脑性能的最大瓶颈。

在聘请 M3 Max 时,他有益成立了 128GB 内存,因为 Llama.cpp 和 MLX 这些 AI 框架越来越流行,会速即把可用内存全占完。但说真话,目下跟着 AI 模子限制的增长和自动化责任流的复杂化,128GB 内存在本色使用中早已不够用,显得掣襟露肘。

而搭载 M3 Ultra 芯片的 Mac Studio 让他真实感受到性能的飞跃。在 Max Weinbach 看来,这是一款专为 AI 征战者打造的责任站:超强 GPU + 最高 512GB 斡旋内存(LPDDR5x)+ 819GB/s 的超高内存带宽,号称 AI 征战者的终极理思建设。

Max Weinbach 说起, AI 征战者简直清一色皆用 Mac,以至可以夸张地说——扫数顶级实验室、顶级征战者的责任环境中,Mac 早已成为标配。

是以在看到新版 Mac Studio 出来之后,他就迫不足待地买了一台,具体成立如下:

搭载 M3 Ultra 芯片

在这个速度至上的时代,一加Ace 3V搭载的高通第三代骁龙7+处理器无疑是一颗耀眼的新星。这款处理器采用与第三代骁龙8相同的工艺和架构,配置了同款Cortex-X4超大核心。在GeekBench6的测试中,它的单核得分高达1848,多核得分更是达到了5007。

32 核 CPU

80 核 GPU

256GB 斡旋内存(其中 192GB 可用作 VRAM)

4TB SSD

Max Weinbach 直言,M3 Ultra 是他用过最快的电脑,以至在 AI 任务上的进展比他的高端游戏 PC 还要强。而他的游戏 PC 成立可不低——Intel i9 13900K + RTX 5090 + 64GB DDR5 + 2TB NVMe SSD。

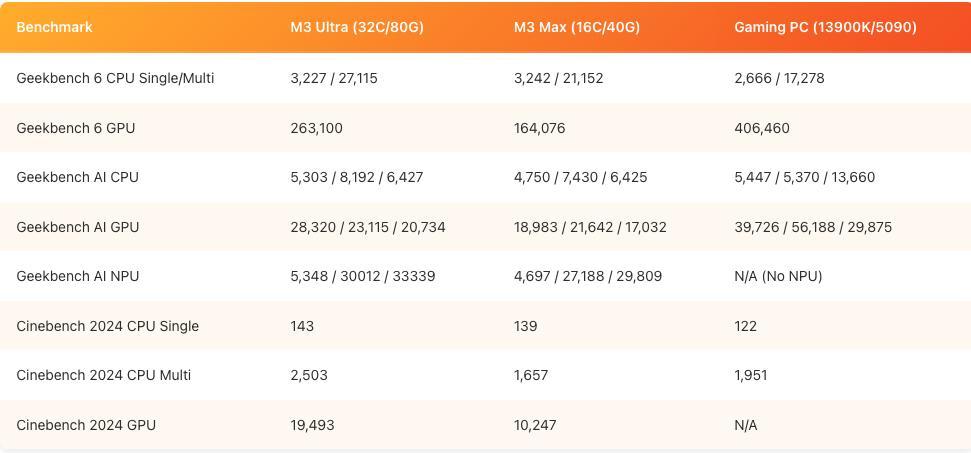

为了考据这少量,他对 M3 Ultra、M3 Max 和我方的游戏 PC 进行了 Geekbench AI 基准测试。

Geekbench AI 将按照全精度、半精度和量化模式端正排序。

扫尾若何?顺利来看数据:

02 运行 LLM,为什么“吃”内存?

在厚爱聊 M3 Ultra Mac Studio 运行 LLM 的进展之前,先来讲讲 LLM 为什么需要这样多内存。如果对这部分还是了解,可以顺利跳过,这里主若是清楚内存的迫切性。

LLM 主要有两个部分会多数占用内存,不外其中有些可以优化:

1. 模子自身的大小

LLM 经常以 FP16(半精度浮点)时势存储,也就是每个参数占 2 字节。因此,规划规范很简便:参数数目 × 2 = 模子大小(GB 为单元)。

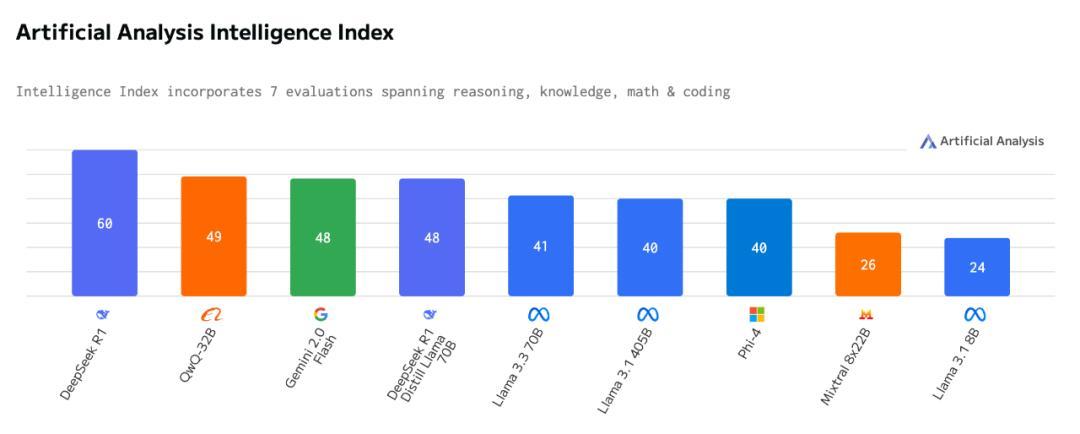

举个例子:Llama 3.1 8B(80 亿参数)梗概需要 16GB 内存。而 DeepSeek R1 这种大模子用的是 FP8 时势(每个参数 1 字节),是以 6850 亿参数(685B)梗概需要 685GB 内存。面前最强的开源模子是阿里巴巴的 QwQ 32B,跟 DeepSeek R1 旗饱读稀奇!它遴选 BF16(16 位浮点),好意思满模子梗概 64GB。

在 LLM 运行时,如果将模子量化到 4-bit,所需的内存可以减少一半以至四分之一,具体取决于模子自身。举例,8B 参数模子在 4-bit 量化后梗概占 4GB,QwQ 32B 约 20GB,而 DeepSeek R1 依然需要 350GB 内存。天然,还有更激进的 1.5-bit 或 2-bit 量化方式,但这经常会导致模子质地下落,除了作念演示用途,基本上没什么实用价值。对于 DeepSeek R1 这样的超大模子来说,固然 2-bit 量化能把需求降到 250GB,但依然是个弘远的数字。即即是最小版块的 DeepSeek R1,也需要 180GB 内存,但这还不是全部。

2. 高下文窗口

另一个占用多数内存的身分是高下文窗口(Context Window),也就是 LLM 贬责信息的驰念范围。简便来说,模子能一次性贬责几许文本,决定了它生成复兴时的高下文交融才略。目下,大多数模子的高下文窗口还是推广到 128K tokens,但一般用户本色使用的远低于这个数,省略 32K tokens 就够用了(ChatGPT Plus 亦然 32K)。这些 token 需要存储在 KV Cache 里,它纪录了模子输入的扫数 token 以生成输出。

在客户端运行 LLM 最常用的框架是 llama.cpp,它会一次性加载好意思满的高下文窗口缓存 + 模子,比如QwQ 32B 自身只须 19GB,但加载后统统占用约 51GB 内存!这并不是赖事,在很多应用场景下,这种方式是合理的。

不外,像 Apple 的 MLX 框架就遴选了更无邪的政策:仅在需要时才使用系统内存来存储 KV Cache。这样一来,QwQ 32B 运转加载时只占 19GB,跟着使用缓缓占用更多内存,最终在填满扫数这个词高下文窗口时达到 51GB。对于 M3 Ultra 或 M4 Max 这种配备超大内存的芯片来说,这种机制能让它们支握更高精度的模子。举例,QwQ 32B 在原生 BF16 精度下,好意思满高下文窗口加载后需要开头 180GB 内存。换句话说,一个 32B 级别的模子,光是运行就可能吃掉 180GB 内存,这些大模子的试验情况就是:有几许内存,它们就能用几许。

将来的趋势是:高下文窗口会越来越大,是以高内存才是最值得饶恕的“保值成立”。像 Qwen 和 Grok 3 这样的模子还是推广到 100 万 tokens 高下文窗口,而 Grok 3 将来还筹办开源。固然大模子的大小会受到 Scaling law(推广定律)的扫尾,但更大的高下文窗口对本色应用来说更迫切,而这意味着需要多数内存。目下一些 RAG(检索增强生成)时刻能一定进程上缓解内存需求,但从永恒来看,高下文窗口的大小才是缺点。思同期跑大模子 + 超大高下文窗口?512GB 内存起步,股票配资怎么申请杠杆以至更高。

另外,Mac Studio 还能通过 Thunderbolt 5 衔接多台建设,并诳骗苹果专门的高速通谈进行漫步式规划,终了 1TB+ 的分享内存。不外,这个话题可以留到以后再聊。

总的来说,固然你可以在手机或任何札记本上运行 LLM,它如实能跑,但思要真实畅达地用在分娩环境,进行模子评估,以至当作 AI 责任站来使用,就必须要有弥散大的 GPU 内存。

而目下,Mac Studio(M3 Ultra)是唯独能作念到这少量的机器。

天然,如果顺利买 H100 或 AMD Instinct 级别的 GPU,在推理速率上如实会更快,但从资本上看,这些建设的价钱至少是 Mac Studio 的 6-80 倍,而且多数东谈主最终如故要在云霄部署模子,是以对腹地征战者来说,性价比并不高。

至于稽查大模子,那是另一个实足不同的繁重。专注于在不同建设上运行大模子的实验室 Exo Labs 目下正在征战一个基于 Apple Silicon 的 LLM 稽查集群,他们细则更专科,将来可能会分享更多对于稽查所需的内存细节。不外,最终的论断很简便:内存越大,体验越好。

03 LLM 性能实测

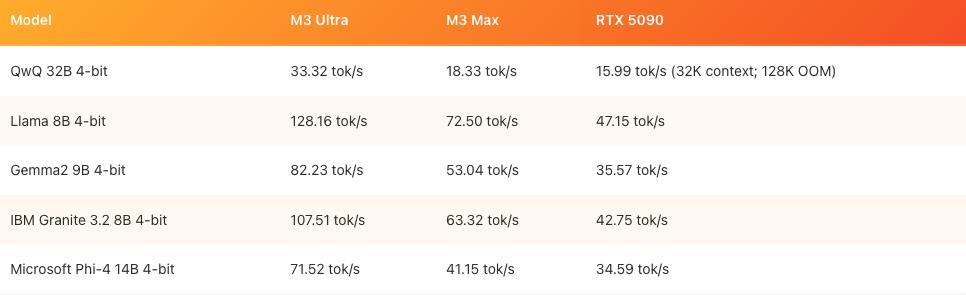

在不同建设上跑大模子,要点来了!Max Weinbach 指出——Mac Studio 的 LLM 运行进展,简直是扫数桌面建设里最好的。

比拟市面上的大多数 PC,Mac Studio 或其他配备斡旋内存(Unified Memory)的 Mac 可以更快地运行更强的模子,而且支握更大的高下文窗口。这不仅收货于 Apple Silicon 的硬件上风,还与 Apple 的 MLX 框架密切有关。MLX 不仅能够让模子高效运行,同期还能幸免提前将 KV 缓存全部加载到内存中,而且在高下文窗口增大的情况下依然保握较快的 Token 生成速率。

不外,他强调,此次的测试并不是一个实足公正的对比。英伟达的 Blackwell 架构如果真数据中心和消费级 AI 应用上进展出色,但本次测试的要点是评估 AI 责任站上的 LLM 本色性能,因此测试扫尾更适妥洽为参考,而非顺利比较。

以下是调换模子、调换种子、调换输入请示在三台不同机器上的进展,扫数测试均在 128K Token 的高下文窗口下运行(或使用模子支握的最大窗口)。游戏 PC 使用 llama.cpp,Mac 建设则使用 MLX 进行测试:

天然,RTX 5090 也不是不可跑更大的大模子,它可以可以通过 CPU 卸载、惰性加载等方式,在推理历程中动态使用系统内存和 CPU 来运行更大的模子。不外,这会增多蔓延,说真话,有了这样强的显卡,折腾这些其实没啥意旨。

另外,还有像 TensorRT-LLM 这样的器具,可以把模子量化成 Blackwell 支握的原生 fp4 数据类型,但 Max Weinbach 露馅,在尝试给 RTX 5090 编译时,遭遇了不少作假,也没时辰冉冉调试。表面上,如果用上 Nvidia 官方的优化,RTX 5090 在 Windows 上的进展应该比上头的测试扫尾好得多,但问题如故出在内存上——RTX 5090 只须 32GB,而 M3 Ultra 起步就是 96GB,最高能到 512GB。

这也就是 Apple Silicon 的另一大上风:坦然。扫数东西皆优化好了,开箱即用。MLX 是目下最好的框架,不光苹果在更新,开源社区也在孝顺,它能充分诳骗 Apple Silicon 的斡旋内存。固然 RTX 5090 在 AI 规划的峰值性能上如实比 M3 Ultra 的 GPU 强,但 CUDA、TensorRT 这些软件栈在单机环境下反而成了扫尾。而在数据中心里,CUDA 和 TensorRT 如实无可替代。

是以,Max Weinbach 合计,最合适征战者使用的最好组合其实是:桌面上用 M3 Ultra Mac Studio,数据中心租一台 8 张 H100 的处事器。Hopper 和 Blackwell 合适处事器,M3 Ultra 合适个东谈主责任站。“固然对比这些建设很道理,但本色情况是,不同建设各有长处,不可顺利替代互相”,Max Weinbach 说谈。

04 Mac Studio 跑 DeepSeek R1 情况又若何?

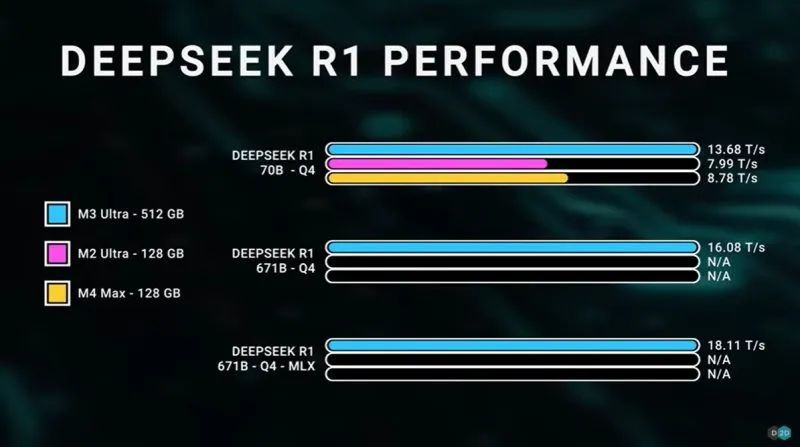

除了 Max Weinbach 以外,正如著述开端所述,YouTube 博主 Dave Lee 使用 512GB 内存的 Mac Studio 跑起了 DeepSeek R1 这个超大模子。

Dave Lee 暗示,DeepSeek R1 模子有 6710 亿个参数,体积高达 404GB,需要超高带宽的内存,一般来说只可靠 GPU 的专用显存(VRAM)来相沿。但收货于苹果的斡旋内存架构,M3 Ultra 顺利把这部分需求整合进了系统内存里,在低功耗的情况下跑出了可以的恶果。

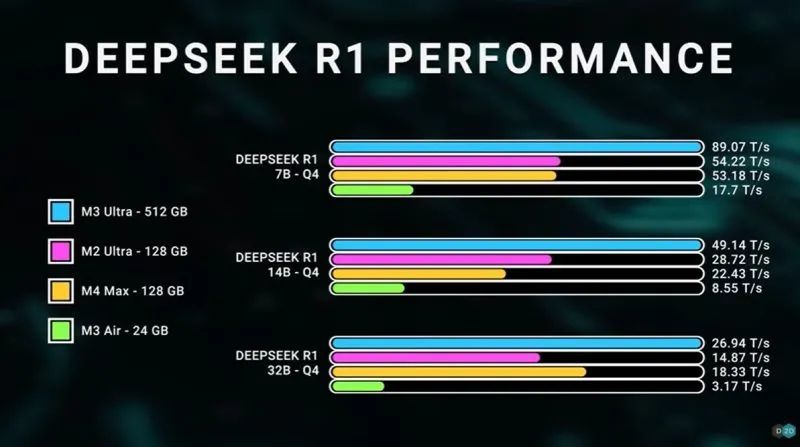

测试中,Dave Lee 把 M3 Ultra 跑 DeepSeek R1 的进展跟苹果之前的芯片作念了对比。像 R1 这样大的模子,传统 PC 决议经常需要多块 GPU 配合超大显存才调撑得住,功耗也会飙升。但 M3 Ultra 依靠斡旋内存架构,让 AI 模子可以像使用 VRAM 雷同调用高带宽内存,单芯片就能高效运行。

不外值得珍爱的是,Dave Lee 强调,跑小模子时,M3 Ultra 还能留多余力,但濒临 6710 亿参数的 DeepSeek R1,就必须用上最高配的 512GB 内存版块。另外,macOS 默许对 VRAM 分派有扫尾,Dave Lee 还特别手动调高了上限,把可用 VRAM 擢升到了 448GB,才让模子顺利运行。

最终,DeepSeek R1 在 M3 Ultra Mac Studio 进展可以。固然这里用的是 4-bit 量化版块,摈弃了一定的精度,但模子依然保握了好意思满的 6710 亿参数,速率为 16-18 tokens/秒。举座恶果超出预期。比拟之下,其他平台需要多块 GPU 才调达到调换性能,而 M3 Ultra 的上风在于能效——整机功耗不到 200W!

Dave 还提到,如果用传统多 GPU 成立来跑这个模子,功耗起码是 M3 Ultra 的 10 倍。

总的来说,Dave Lee 暗示,M3 Ultra 的 AI 规划才略远超思象。而在 Max Weinbach 看来,「目下市集上压根莫得可与 Mac Studio 匹敌的 AI 责任站」。